솔직히 말해서, AI가 제 코드를 대신 작성하고 심지어 실행까지 한다고 생각하면 기대와 함께 살짝 걱정이 되는 건 저뿐만이 아닐 거예요. 특히나 **Google Antigravity**처럼 AI 에이전트가 개발 워크플로에 깊숙이 통합되어 자율적으로 코드를 작성하고 환경을 제어하는 플랫폼이라면, **보안(Security)**과 **신뢰(Trust)** 문제는 정말 핵심 중의 핵심이겠죠. 우리가 다루는 데이터와 코드베이스는 너무나 소중하니까요. 이 글을 통해 Antigravity가 이 두 가지 중요한 가치를 어떻게 지켜내는지, 그 체계적인 접근 방식을 자세히 설명해 드릴게요. 😊

1. 보안 최우선 설계 (Security-First Design) 🔒

Antigravity의 설계 철학은 명확합니다. 처음부터 **제로 트러스트(Zero Trust)** 모델을 기반으로 한다는 것이죠. 다시 말해, 모든 구성 요소는 기본적으로 신뢰하지 않고, 오직 명시적인 권한과 철저한 검증을 통해서만 접근이 허용됩니다. 불필요한 위험을 원천 차단하는 가장 기본적인 방어선이라고 할 수 있어요.

1.1. 최소 권한 원칙 (Principle of Least Privilege, PoLP)

에이전트가 무슨 일을 하든 딱 그 일에 필요한 **최소한의 권한**만 부여합니다. 이건 개발팀이 직접 설정해야 하는 가장 중요한 부분 중 하나예요. 예를 들어볼까요?

- **세분화된 접근 제어:** UI 개선 작업을 하는 에이전트에게 굳이 데이터베이스 수정 권한을 줄 필요는 없겠죠? 개발자는 작업 범위에 맞춰 접근 권한을 **명확히** 설정해야 합니다.

- **시간 제한 권한 (Time-Bound Permissions):** 특정 버그 픽스처럼 한시적인 작업에는 해당 기간 동안만 유효한 **임시 권한(Ephemeral Permissions)**을 설정할 수 있어요. 작업이 완료되면 권한은 자동으로 회수되어 오용될 여지를 최소화합니다.

1.2. 샌드박스 및 격리 환경 (Sandbox and Isolated Environments)

AI가 생성한 코드나 테스트 실행은 주된 개발 환경에 영향을 주지 않도록 완벽히 격리된 안전한 공간에서 이루어집니다. 마치 보호막 안에 가두고 테스트하는 것과 같아요.

에이전트가 코드를 테스트하거나 임시 종속성을 설치하는 과정은 **컨테이너화된(Containerized) 환경**에서 실행됩니다. 이는 잠재적인 악성 코드나 불안정한 코드가 광범위하게 확산되는 것을 효과적으로 방지해줍니다.

2. 검증 가능한 산출물 및 투명성 (Verifiable Artifacts and Transparency) 👀

AI 에이전트의 작업이 ‘블랙박스’처럼 느껴진다면 신뢰하기 어렵겠죠? Antigravity는 **투명성(Transparency)**과 **검증 가능성(Verifiability)**을 핵심 요소로 내세웁니다. 모든 것이 기록되고 개발자에게 보고됩니다. 정말 꼼꼼하게 말이에요!

2.1. 작업의 상세 기록 및 감사 추적 (Audit Trails)

에이전트가 수행하는 모든 작업은 변경 불가능한(Immutable) 기록으로 남습니다.

- **엔드-투-엔드 감사:** 어떤 파일을 열었는지, 코드를 어떻게 수정했는지, 터미널 명령이 무엇이었는지 등 모든 활동이 상세히 기록됩니다. 이 기록은 나중에 보안 감사나 문제 발생 시 **원인 파악**에 결정적인 역할을 해요.

- **산출물 기반 검토:** 코드가 병합되기 전, 개발자는 에이전트가 생성한 구현 계획, 테스트 결과, 스크린샷 등의 **시각적 산출물**을 통해 작업의 품질과 의도를 쉽게 검토할 수 있습니다.

2.2. 인간 중심의 검토 루프 (Human-in-the-Loop Review)

AI가 아무리 자율적이라도 **최종 통제권은 언제나 개발자**에게 있습니다. 인간의 개입이 신뢰를 완성하는 열쇠죠.

- 명시적 승인 (Explicit Approval): 중요한 코드 변경이나 시스템 설정 업데이트는 개발자의 **명시적인 승인** 없이는 실행되지 않습니다. Git Pull Request(PR)와 유사한 검토 과정을 거쳐 최종 확인합니다.

- 실시간 피드백 및 조정: 개발자는 에이전트 작업 도중에도 실시간으로 피드백을 주어 작업 방향을 수정하거나, 위험해 보이는 작업을 **즉시 중단**시킬 수 있어요.

3. 데이터 및 모델 보호 (Data and Model Protection) 🛡️

우리 회사의 민감한 코드베이스가 다른 곳에 흘러가거나 AI 학습에 사용되면 안 되겠죠? Antigravity는 이를 엄격하게 관리합니다.

3.1. 학습 데이터 격리 (Training Data Isolation)

Google은 개발 팀의 프라이빗 코드베이스는 **AI 모델 학습에 사용되지 않는다**는 원칙을 명확히 하고 있습니다. 여러분의 코드는 에이전트가 현재 작업을 수행하는 **컨텍스트(Context)**로만 활용됩니다. 모델 자체가 여러분의 코드를 외워서 다른 곳에 재사용하는 일은 일어나지 않아요.

Antigravity는 분석 목적으로 코드 스니펫이나 오류 보고서를 수집할 수 있지만, 이 과정에서 API 키, 사용자 데이터 등 **민감한 식별 정보는 철저히 제거**된다고 하니 안심해도 될 것 같아요.

3.2. 보안 코드 생성 및 검증 (Secure Code Validation)

에이전트가 생성하는 코드 자체의 안전성도 검증하는 메커니즘이 내장되어 있습니다. 단순히 코드를 짜는 것뿐만 아니라, **보안 전문가 역할**까지 수행하는 셈이죠.

- **잠재적 취약점 검사:** 코드를 작성하는 과정에서 **OWASP Top 10**과 같은 일반적인 보안 취약점(SQL Injection, Cross-Site Scripting 등)을 자동으로 검사하여 즉시 수정하거나 개발자에게 경고합니다.

- **의존성 안전성 확인:** 새로운 라이브러리나 패키지를 추가할 때도, 해당 의존성의 알려진 보안 취약점 기록을 자동으로 확인하고 문제가 있다면 대체 솔루션을 제안합니다.

4. 책임 있는 AI 및 롤백 기능 (Accountability and Rollback) ↩️

AI가 실수를 하더라도 누가 책임을 져야 할까요? Antigravity는 이 질문에 명확히 답합니다. 책임 소재를 명확히 하고 문제가 생겼을 때 되돌릴 수 있는 장치를 마련해 두었어요.

명확한 책임 소재 및 쉬운 롤백

Antigravity를 통해 생성 및 수정된 모든 코드는 Git과 같은 **버전 관리 시스템**에 통합됩니다. 덕분에 커밋 기록에는 해당 변경 사항을 **누가(개발자 또는 특정 에이전트)** 승인하고 실행했는지 명확하게 기록됩니다. AI도 시스템 내에서 책임의 주체로 다뤄지는 거죠.

쉽고 빠른 롤백 기능 📝

에이전트가 의도치 않게 오류를 발생시켰다면요? 걱정 마세요. 이전에 기록된 감사 추적과 버전 관리 시스템을 활용하여 개발자는 단일 명령으로 쉽게 **이전 상태로 되돌릴 수 있는(Rollback)** 기능을 제공받습니다. 오류를 수정하는 것보다 훨씬 빠르고 안전하겠죠!

Google Antigravity 보안 및 신뢰 핵심 요약 📝

자, 지금까지 설명드린 Antigravity의 보안 및 신뢰 원칙을 한눈에 정리해 볼까요? 이 플랫폼이 어떻게 효율성과 안정성을 동시에 잡으려 노력하는지 핵심만 쏙 뽑아 정리했습니다!

- 최소 권한 & 격리: 에이전트는 필요한 최소 권한만 가지며, 모든 코드는 격리된 샌드박스 환경에서 실행됩니다.

- 투명성 & 검증: 모든 작업 단계가 상세히 기록되며, 코드를 병합하기 전 개발자가 시각적 산출물을 통해 **쉽게 검토(Human-in-the-Loop)**할 수 있습니다.

- 데이터 보호: 프라이빗 코드는 모델 학습에 사용되지 않으며, 민감 정보는 철저히 익명화됩니다.

- 보안 코드: 생성된 코드 자체의 잠재적 취약점을 자동으로 검사하고 수정합니다.

- 책임 & 롤백: 모든 변경 사항은 명확한 책임 소재와 함께 기록되며, 문제가 발생하면 쉽게 이전 상태로 **롤백**할 수 있습니다.

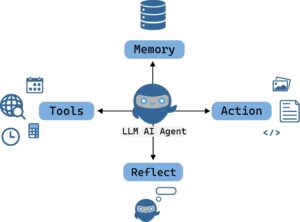

Antigravity 신뢰의 3가지 기둥

자주 묻는 질문들 ❓

결국 **Google Antigravity**의 보안 및 신뢰 원칙은 ‘최소 권한’과 ‘개발자의 통제권’이라는 두 축을 중심으로 움직인다고 볼 수 있습니다. AI의 효율성을 극대화하면서도, 엔터프라이즈 환경에서 가장 중요한 **안정성**과 **보안**을 놓치지 않으려는 Google의 철학이 잘 담겨있는 것 같아요. 😊